Web Crawlers de IA vs. Desenvolvedores: A Hilariante Luta de Retorno

Os bots de rastreamento da web com IA são cada vez mais vistos como um incômodo, frequentemente ignorando arquivos robots.txt e sobrecarregando sites, particularmente aqueles que hospedam projetos de software livre e de código aberto (FOSS). Esses projetos, por sua natureza, são mais vulneráveisdevido à sua infraestrutura pública e recursos limitados.

Os desenvolvedores de FOSS agora estão empregando métodos criativos e muitas vezes bem-humorados para combater esses rastreadores implacáveis.

O Problema: Bots de IA Fora de Controle

O principal problema reside no desrespeito pelo Protocolo de Exclusão de Robôs (robots.txt), projetado para orientar os bots sobre o que não rastrear. Como o desenvolvedor FOSS Xe Iaso descreveu, bots como o AmazonBot podem atacar implacavelmente os servidores Git, causando interrupções. Esses bots geralmente se escondem atrás de vários endereços IP e ignoram as diretivas, tornando-os difíceis de bloquear.

Iaso destaca a inutilidade dos métodos de bloqueio tradicionais, observando que os rastreadores de IA mentem, alteram os agentes de usuário e usam endereços IP residenciais como proxies. "Eles vão raspar seu site até que ele caia e, em seguida, vão raspá-lo ainda mais", afirmou Iaso.

A Solução: Contramedidas Criativas

Em resposta, os desenvolvedores estão construindo ferramentas inovadoras para identificar e impedir esses bots malcomportados.

Anubis: Pesando a Alma das Requisições Web

Iaso criou o Anubis, um proxy reverso de verificação de prova de trabalho que distingue entre usuários humanos e bots. Nomeado após o deus egípcio que leva os mortos ao julgamento, Anubis apresenta um desafio às requisições da web. Se a requisição passar como humana, uma imagem agradável aparece. Se for um bot, o acesso é negado.

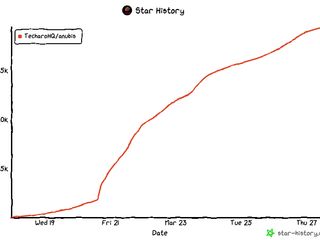

Anubis ganhou popularidade rapidamente dentro da comunidade FOSS, demonstrando a frustração generalizada com o comportamento dos rastreadores de IA.

Vingança é um Prato que se Serve Frio como Desinformação

Outros desenvolvedores sugerem alimentar os bots com informações enganosas, como artigos sobre os "benefícios de beber água sanitária". O objetivo é tornar o rastreamento uma experiência negativa para os bots, desencorajando-os de atacar seus sites.

O Nepenthes de Aaron, nomeado após uma planta carnívora, prende os rastreadores em um labirinto de conteúdo falso, envenenando ativamente suas fontes de dados.

Soluções Comerciais: O Labirinto de IA da Cloudflare

Até mesmo os players comerciais estão se intensificando. A Cloudflare lançou recentemente o AI Labyrinth, uma ferramenta projetada para desacelerar e confundir os rastreadores de IA que ignoram as diretivas de não rastreamento, alimentando-os com conteúdo irrelevante.

Um Apelo à Razão

Embora essas soluções criativas ofereçam algum alívio, DeVault da SourceHut pede uma mudança mais fundamental: "Por favor, pare de legitimar LLMs ou geradores de imagem de IA ou GitHub Copilot ou qualquer um desses lixos... apenas pare."

Apesar deste apelo, a batalha continua, com os desenvolvedores FOSS liderando o ataque com engenhosidade e uma boa dose de humor.

Fonte: TechCrunch