Aya Vision da Cohere: Modelo Aberto de IA para Compreensão Multilíngue

Cohere For AI, o braço de pesquisa da startup de IA Cohere, acaba de lançar uma bomba: Aya Vision, um modelo de IA multimodal "aberto" que eles estão promovendo como o melhor da categoria. Mas o que isso realmente significa para você?

Essencialmente, o Aya Vision pode lidar com várias tarefas legais. Pense em escrever legendas para imagens, responder a perguntas sobre essas fotos, traduzir texto como um profissional e até gerar resumos em 23 idiomas principais! A Cohere está até disponibilizando gratuitamente via WhatsApp, com o objetivo de democratizar o acesso à pesquisa de IA de ponta.

Preenchendo a Lacuna de Idiomas

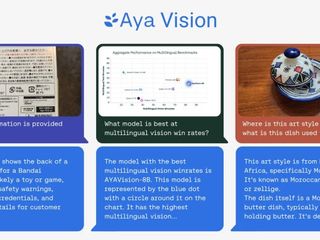

Cohere destaca um grande problema no mundo da IA: viés de idioma. Os modelos geralmente têm um desempenho muito melhor em inglês, deixando outros idiomas para trás, especialmente em tarefas que envolvem imagens e texto. O Aya Vision foi projetado especificamente para lidar com essa lacuna.

Dois Sabores de Aya Vision

Você tem duas opções aqui: Aya Vision 32B e Aya Vision 8B. A versão 32B é a mais pesada, aparentemente superando modelos duas vezes maiores, incluindo o Llama-3 90B Vision da Meta, em certos testes de compreensão visual. A versão 8B também se mantém firme, superando até mesmo modelos dez vezes maiores em algumas avaliações.

Ambos os modelos estão disponíveis no Hugging Face sob uma licença Creative Commons 4.0, mas há um porém: eles não são para uso comercial.

Dados Sintéticos para o Resgate?

Aqui é onde as coisas ficam interessantes. O Aya Vision foi treinado usando uma mistura de conjuntos de dados em inglês, que foram traduzidos e usados para criar anotações sintéticas. Essas anotações atuam como tags ou rótulos, ajudando o modelo a entender e interpretar os dados durante o treinamento. Pense nisso como rotular objetos em uma foto para que a IA saiba o que está vendo.

O uso de dados sintéticos está se tornando cada vez mais comum à medida que o fornecimento de dados do mundo real diminui. Até mesmo o OpenAI está aderindo à tendência. A Gartner estima que impressionantes 60% dos dados usados para projetos de IA no ano passado foram gerados sinteticamente.

A Cohere afirma que treinar o Aya Vision com anotações sintéticas permitiu que eles alcançassem um desempenho competitivo com menos recursos. Esse foco na eficiência é crucial, especialmente para pesquisadores com poder computacional limitado.

Um Novo Benchmark: AyaVisionBench

Cohere não está apenas lançando um modelo; eles também estão introduzindo o AyaVisionBench, um novo conjunto de benchmarks para avaliar as habilidades de um modelo em tarefas de visão-linguagem. Isso inclui coisas como identificar diferenças entre imagens e converter capturas de tela em código.

A indústria de IA está enfrentando uma "crise de avaliação" porque os benchmarks atuais geralmente não refletem com precisão o quão bem um modelo se comporta em cenários do mundo real. A Cohere espera que o AyaVisionBench resolva isso, fornecendo uma maneira mais abrangente de avaliar a compreensão multilíngue e multimodal.

O Objetivo: IA Melhor e Mais Acessível

Em última análise, o objetivo da Cohere é criar uma IA que não seja apenas poderosa, mas também acessível a uma gama maior de pesquisadores e usuários. Ao se concentrar na eficiência, nas capacidades multilíngues e na avaliação robusta, o Aya Vision pode ser um passo significativo na direção certa.

“[T] o conjunto de dados serve como um benchmark robusto para avaliar modelos de visão-linguagem em configurações multilíngues e do mundo real”, escreveram os pesquisadores da Cohere em uma postagem no Hugging Face. “Disponibilizamos este conjunto de avaliação para a comunidade de pesquisa para impulsionar avaliações multimodais multilíngues”.

Source: TechCrunch